Lorsque l’on fait un audit SEO , il y a plusieurs types de rapport SEO, du plus succinct au rapport très complet. Il y a aussi des outils, des sites à utiliser, un audit SEO c’est un mélange de tout cela. Lorsque l’on fait un audit cela peut être pour un devis pour faire du référencement, cela peut être aussi un audit sur un site concurrent, pour savoir pourquoi il est bien placé , les forces et les faiblesses de ce site.

Les seules choses qui diffèrent entre un site ou on a accès à tout et un site concurrent, c’est l’accès ou pas aux données confidentielles comme Analytics et ou Google Webmaster Tools.

Cela peut être aussi utile de faire un audit SEO sur un site avant de le racheter, savoir son historique, ce qu’ils ont fait dessus, bref savoir ce que l’on achète.

Voici un liste des choses à voir et des points à vérifier.

L’audit SEO : 7 points à surveiller.

- Nom de domaine et hébergement

- Les pages indexées dans Google

- sitemap robots.txt redirection

- le contenu de votre site

- le code source

- Le net linking les backlink

- les réseaux sociaux

Nom de domaine et hébergement

Lorsque l’on parle audit SEO il faut un site web et un hébergement, c’est mieux… Il faut aussi des outils pour aller plus vite et être efficace dans l’audit, je vous parlais déjà des extensions SEO pour Firefox.

La première des extensions que j’utilise est l’extension SEO Flagfox, j’en profite ici pour vous glisser un lien vers une ancre vers un autre article, en réponse au Juge. Avec Flag fox et le Geotool, vous avez beaucoup d’infos en quelques secondes. Un exemple

Un capture d’écran de Geotool avec l’extension Flagfox

Vous avez l’IP et la localisation du serveur, toujours avec Flagfox, faites un clic droit sur le drapeau dans la barre d’adresse, vous avez le Whois, archive.org etc.. et bien d’autres encore.

Si vous êtes hébergé en Californie, il sera un peu plus difficile de bien se placer sur le marché français et plus long en temps de réponse aussi.

Le nombre des options disponibles est vraiment importante. Flagfowx va vous donner beaucoup d’infos importantes, facilement accessibles en 1 clic pour tout ce qui est hébergement et historique du site.

Les pages indexées dans Google

Toujours avec Flagfox, vous pouvez afficher le nombre de pages indexés dans Google en un seul clic, je vais vous donner une astuce, ajouter ensuite & à la fin de l’URL vous aurez les pages indexées dans l’index primaire, le bon index de Google, si vous avez une très grosse différence, ce n’est pas bon signe cela veut dire qu’il y a du duplicate content sur votre site.

Un bon exemple vaut mieux qu’un long discours, je dispose d’un vieux site http://www.joomla-webmaster.com que je n’utilise plus beaucoup, ce site a un souci de duplicate content évident :

- site:https://www.joomla-webmaster.com/ : 16 800 résultats

- site:https://www.joomla-webmaster.com/& : 865 résultats

Le résultat est édifiant, il faut vraiment que je me penche sur ce soucis de duplicate content, c’est le composant de rewriting qui pose soucis.

Regardez aussi le nombre de pages indexés ce dernier mois dans Google, Si vous publiez régulièrement du contenu de qualité, ce contenu est normalement indexé en quelques minutes, cela peut être beaucoup plus long si le site présente des soucis de qualité ou si il y a peu de nouveautés. Sur ce site c’est la première fois que je publie un article sur le webmarketing,

une image vaut mieux qu’un long discours:

on voit ici que je n ‘ai qu’une url indexée car ce site a eu peu de rédaction et de contenu inséré en un mois

C’est aussi signe que le site bouge peu, car pas de temps, etc.. il faut c’est certain, de la rédaction web pour qu’un site progresse en qualité, il doit rendre service aux utilisateurs, cet article va faire cela.

La vitesse du serveur

Cela fait déjà beaucoup de temps que les moteurs de recherche tiennent compte de la vitesse du site, plusieurs raisons à cela: un site web rapide qui répond bien aux requêtes est plus agréable à visiter, il y a une autre raison moins facile à voir au premier abord, Les moteurs de recherche ont de plus en plus de sites à indexer, mais même en augmentant sans cesse les serveurs, le nombre de sites web dans le monde devient totalement exponentiel.

Ce qui veut dire que le temps alloué par Google pour indexer votre site n’augmente pas ou pas autant que vous le souhaiteriez. Il faut donc mettre à profit le temps imparti pour que le robot puisse aller vite sur votre site, si le site est très lent, Googlebot passera beaucoup de temps sur peu de pages et passera certainement à coté des nouvelles pages mis en ligne récemment.

Nous n’avons pas le choix, Google a décidé de pénaliser les sites lents puisque ce paramètre est maintenant dans l’algorithme de Google. Attention lorsque vous êtes sur un serveur mutualisé, un site web voisin peut prendre toutes les ressources du serveur, bien sûr la plupart des hébergeurs surveillent ce qui se passe. Cependant entre les ralentissements et les mesures prises pour ne plus freiner les autres sites, il peut se passer un certain temps.

Pour voir comment va votre site d’un point de vue vitesse, vous pouvez utiliser l’extension SEO Lori, vous trouverez aussi un excellent service avec Pingdom.

Toujours à propos du serveur, si vous avez un hébergement mutualisé, il est important de savoir qui et combien de site web sont hébergé par votre serveur, c’est très facile de le savoir avec une commande en ligne ou une extension SEO.

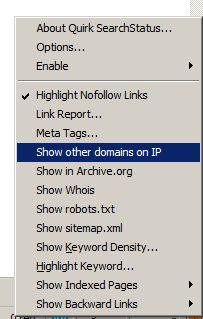

- Search Status pour savoir le nombre de site hébergé sur votre serveur: Search status

- Ligne de commande sur Bing

Avec search status, sur la page d’accueil de votre site faites un clic droit et lancer “show other domain on IP ” cela lance Bing avec la commande ip:”votre IP”

sitemap robots.txt redirection

Une fois fait l’audit sur le serveur, les pages indexées par Google, on peut se pencher sur comment est le site web et comment il réagit. Il faut vérifier ces points suivants sur le site.

- redirection du site sans www vers le www

- Gestion correcte des entêtes HTTP

- mise en place du robots.txt

- le sitemap.xml

Redirection du site sans www vers le www

Il arrive qu’un site soit disponible via plusieurs URL: exemple

- https://www.webmarketing-seo.fr/

- https://webmarketing-seo.fr/

- https://www.webmarketing-seo.fr/index.php

Ces URL doivent toutes renvoyer vers une seule et même URL cela évite le duplicate content, ces redirections doivent être en 301.

Gestion correcte des entêtes HTTP

Vous devez aussi avoir une gestion correct des entêtes HTTP, les entêtes HTTP, c’est le code que renvoie chaque page HTML, on peut le consulter avec la barre web developper. Une page qui fonctionne renvoie un code 200, votre page 404 doit renvoyer un code 404, à vérifier !!

mise en place du robots.txt

Le fichier du robots.txt est un fichier qui sert à aider l’indexation d’un site en autorisant ou refusant des moteurs de recherche, ou des répertoires ou des urls, ce fichier n’est pas une obligation mais plutôt un signe de bonne pratique. Il doit être à la racine du site et donne des instructions aux bot. En savoir plus sur les fichiers robots.txt

Le sitemap.xml

Le sitemap.xml est à mon sens un peu plus important puisque vous pouvez le déclarer auprès des moteurs de recherche dans votre interface Google Webmaster Tools comme Bing Webmaster tools. Les deux outils sont indispensables. Le sitemap.xml est vraiment important pour les très gros sites et vous pouvez y déclarer les images, les vidéos .

Si le site est à vous, vous avez accès dans GWT et Bing Webmaster Tools à un rapport sur comment Google ou Bing voit vos Sitemap. Il est prudent de s’y pencher de temps en temps . La plus part du temps le sitemap est accessible sans problème à cette adresse “votresite/sitemapl.xml” https://www.webmarketing-seo.fr/sitemap.xml

Besoin de précisions, de méthodes tout est expliqué dans le site officiel, il y a beaucoup d’information à consulter. En savoir plus sur les sitemap

le contenu de votre site

Le contenu du site, on arrive au cœur de l’audit, en fait sur une note de 1 à 20, mettez objectivement une note à ce contenu, il faut vous poser des questions en terme de qualité, d’unicité. Est ce que ce contenu rend service à vos visiteurs ? A l’heure ou le contenu de qualité est vraiment important avec les différentes versions de Panda et Pingouin.

Posez vous ces questions :

- Mots clés

- Contenu: la qualité des textes des informations, l’unicité du contenu

- Rythme de diffusion du contenu

- Respect des bonnes pratiques: écrire pour le web

- Les liens sortants dans vos articles, dans votre site

- Linkage interne dans votre contenu

- Page de liens utiles

- Gestion des erreurs 404 et de leurs redirections

Mots clés

Avez vous les bons mots clés ? sont ils bien répartis sur votre site ? Est ce que votre thématique est bien exploité avec les mots clés forts et la longue traine ? Comment sont les sites concurrents sur ce sujet ? Faites vous un suivi de positionnement sur ces mots clés ?

Contenu la qualité des textes des informations, l’unicité du contenu

Un site aura une bonne audience si il présente du contenu de qualité, ce n’est pas la première fois que je le dis mais c’est vraiment cela, il y a tellement de sites maintenant, que pour sortir du lot il va vraiment falloir faire quelque chose de qualité. avec des textes écrits pour les internautes, ce sont eux qui finalement vous feront du référencement en relayant vos informations. Bien sûr ce n’est pas simple, ce n’est pas immédiat, il va vraiment falloir mouiller le maillot pour y arriver, Google a de plus tendance à garder le visiteur sur son site un exemple le knowledge graph.

Rythme de diffusion du contenu

Publiez vous régulièrement sur votre site ou une fois tous les 6 mois ? Prenez vous le temps chaque semaine ou tous les 15 jours pour publier une news, une actu ? Oui c’est difficile, c’est difficile de perverer, de tenir le rythme, il faut trouver des sujets, prendre le temps d’écrire un article.

Un article comme celui ci c’est plusieurs heures de travail, le texte est bien sûr unique, j’ai pris la peine et le temps de réfléchir au sujet, j’ai trouvé aussi de sources sur internet que je vais citer en bas de cet article, je ne prétends pas tout savoir mais citerai les articles que j’ai trouvé intéressant et qui sont encore d’actualité et pertinent.

Respect des bonnes pratiques: écrire pour le web

La rédaction web un vrai métier

Lorsque vous écrivez du contenu, des articles, savez vous qu’il y a une manière bien particulière d’écrire pour le web. On écrit pour l’internaute et aussi pour les moteurs de recherche. Si ce n’est pas trop le cas, je vous engage fortement à lire cet article : >https://www.redigeons.com/ecrire-un-article-la-methode/ ou cet ensemble d’article pour pratiquer une bonne rédaction web, une rédaction efficace.

Les liens sortants dans vos articles, dans votre site

Est ce que vous mettez des liens sortants dans vos articles dans vos rubriques ? Lorsque vous parlez, décrivez une actualité. Un lien vers un article référence n’a jamais fait de tort à un article ou un site web, je ne vous parle pas de faire n’importe quoi en terme de liens sortants. mais de mettre des liens pertinents. à lire :faites des liens sortants

linkage interne dans votre contenu

Est ce que votre contenu dispose d’un bon linkage interne, un linkage efficace qui ne soit ni trop important ni trop faible, Un linkage qui rend la navigation agréable, intuitive, une navigation qui rend service à l’internaute

Page de liens utiles

Avez vous une page de liens utiles, une page partenaire qui soit une vraie page partenaire ? Un page qui n’est pas un sapin de Noël mais une page avec des textes de qualité et des liens vers des sites de référence. Si ce n’est pas le cas, Une petite piqure de rappel ne fera pas de mal : Gestion de la page partenaires.

Gestion des erreurs 404

Si vous êtes le propriétaire du site, vous avez accès à Webmaster Tools de Google et Bing, allez faire un tour dans dans les erreurs d’exploration, il faut corriger ces erreurs 404 surtout si elles sont très nombreuses. Si vous ne savez pas comment faire : un peu de lecture : GWT donne des infos sur les erreurs d’exploration.

Le code source

Explorez le code source du site, est ce que le site utilise de la technologie flash, des liens javascript, du contenu caché aux visiteurs, est ce que le site contient des facteurs bloquants comme beaucoup de liens vers une page sans importance, vos images n’ont pas de balises Alt renseigné correctement par exemple. est ce que le site passe les validations w3c ?

Le net linking les backlink

Sur un domaine concurrentiel, c’est la que ça va se jouer. Pour étudier le netlinking, il existe plein d’outils sur le net. je vais vous citer les plus sérieux.

La plupart ont une partie ou une version gratuite ou d’essais. Mais à la fin ils sont tous payants, ils sont cependant des outils de qualité, Majestic SEO, Ahrefs, Opensiteexplorer sont très bien pour trouver les liens et vous donner une idée du net linking.

Ils mélangent tous des données types Excel et des données en graphe, la répartition nofollow dofollow sur Ahrefs est vraiment bien faite. Les informations que vous allez trouver sont vraiment de qualité comme le type d’ancre que vous avez sur un site, la répartition liens, domaine et IP par exemple, etc… …

Advanced Web Ranking est un outil un peu part, il fait du suivi de positionnement, il est vraiment excellent pour cela, il suit vos mots clés, vos sites et les sites des concurrents sans aucun problème, son seul défaut serait la lenteur de mise à jour lorsqu’on a beaucoup de mots clés, AWR est de plus en plus orienté vers l’audit, il vous permet d’auditer comparer des sites, avec beaucoup de fonctionnalités très intéressantes dans la version 9.3.

Les réseaux sociaux

Maintenant, se passer des réseaux sociaux est une aberration qu’on le veuille ou non, il est indispensable de surveiller ce qui se passe sur les réseaux sociaux et sur vos réseaux sociaux, leur audit fait parti des choses indispensables à faire. Si ce n’est pas fait correctement cela peut être catastrophique, par exemple acheter des comptes Facebook des comptes twitter on trouve facilement ce genre de prestation sur le net. Cela sert juste a flatter l’ego mais question ROI vous aurez rien ou pas grand chose. Alors de grace investissez dans une prestation réseaux sociaux sérieuse.

Voila un peu le tour sur ce que l’on peut faire pour un audit que ce soit un site à vous, ou le site d’un de vos concurrents, il y a un certain nombre de points à surveiller.

Comments (24)

Et bien pour un article que je pensais publicitaire, tu t’en sors plutôt très bien.

Un article bien fourni avec des informations pertinentes et surtout avec des véritables petites astuces pour réussir son Audit, qu’il soit pour un site personnel ou bien pour un site client.

Vraiment pas mal du tout, c’est article à bookmark pour les petits SEO en agence qui traîneront pas ici.

Je ne connaissais pas flagfox, c’est hyper pratique ! Bon article, peut-être il manque des liens vers des outils d’audit de réseaux sociaux, nombre de lines, de like etc… (j’ai pas mes bookmarks sous la main… vacances 🙂

Je pense qu’il y a matière à pousser un peu plus l’article, particulièrement vis à vis de l’analyse du crawl du site, des meta / title / H1 / H2.

Quoiqu’il en soit l’article est tout de même sympa il faut le dire aussi ^^

Merci pour les astuces et les plugins, ça nous fait gagner du temps. Je rajoute cet article dans les “astuces SEO” ^^ Merci !

Merci pour l’article, tu passes en revue les choses importantes sans te perdre dans les cas particuliers (et chaque audit est un cas particulier).

Tous les points sont a approfondir en fonction du site à analyser.

j’aime donc je twitt !

merci pour cet article. il est toujours bon de rappeler ces différents points.

Et pas mal l’astuce avec le /& dans la recherche google. Je connaissait pas 🙂

Bon récapitulatif complet sur l’audit SEO.

Personnellement, j’aurai tout de même ajouté tout ce qui tourne autour du .htaccess (si le client utilise Apache comme serveur HTTP) pour vérifier les bonnes redirections 301 notamment.

Bonne soirée.

Bon petit article même si cela n’apporte pas vraiment de nouveautés sur les audits SEO cela reste important de le rappeler.

Par contre sympa l’astuce du /& que j’ignorais possible de cette façon.

Je vous met en favori en espérant vous relire bientôt avec d’aussi bon contenus.

Très efficace vos recommandations pour l’audit seo , un article complet et utile

l’astuce /& est top

Article à bookmarker !

Bravo c’est un bon résumé, l’article nous permet de classifier les étapes et d’avancer de façon ordonner. Merci !

Il y a t’il une méthode gratuite pour analyser les backlink ?

ahref c’est très limité gratuitement

Voilà un joli inventaire de recettes pour se mettre au piano du SEO.

Cela dit, le petit truc “&” mérite de citer ses sources pour que l’on y croit vraiment, d’autant que l’affaire du supposé double index est un véritable serpent de mer, Google ayant déjà nié jusqu’à l’existence du monstre à 2 têtes en 2007.

Pour ce qui est du contenu, j’insisterai lourdement sur l’importance et la corrélation au niveau des mots-clés, des balises Title, H1 er de l’URL des pages, qui se doivent toujours effectivement d’être on ne peut plus fresh.

Et au final si vous n’êtes pas collectionneur d’extensions Firefox et disposez d’un petit budget, offrez-vous un joli bouquet de logiciels de chez Powersuite. Il y en 4 mais les 3 font la paire notamment au niveau de l’audit et du linkbaiting: Spyglass, Web Site Auditot et Rank Tracker. En plus ils ont une hotline à la Flash Gordon. Merci Eric.

Excellent article sur le sujet! Merci 🙂

Bonjour,

Merci pour cet article très complet. J’ai trouvé les éléments particulièrement intéressant pour la page partenaires. J’avais souvent entendu dire qu’il fallait l’abandonner.

Encore Merci !

Merci pour cette article.

Il manque peut-être plus d’informations au niveau interne, tels que l’optimisation des metabalises ou encore l’intérêt des liens internes

La petite astuce du “&” est pas mal du tout !

La suite de powersuite est vraiment pas mal pour faire les audits, elle reprend plusieurs points de cet article, je le conseille aussi, pour ceux qui ont un budget à investir..

Article très complet. Merci beaucoup pour toutes ces informations et liens qui seront très utiles.

Pour moi, c’est sans aucun doute enrichissant.

Article très complet sur l’audit SEO. Pour ma part, j’utilise Xenu ou Screaming Frog SEO pour scraper l’ensemble des pages d’un site, ce qui permet d’obtenir les pages 404…et autres erreurs. Après je peux débuter l’analyse du site. A+ Marie

Merci pour ton article très enrichissant et plutôt complet ! Je confirme que Xenu est génial pour scrapper toutes les URLs de son site afin de déceler les possibles erreurs de meta description / meta title. De plus, il nous est possible de voir les R301 et les liens morts, très utiles lors d’un audit SEO. Paulo 😉

Super article, merci pour le partage, toujours de super trouvaille sur votre blog! A bientot, matt

J’ai testé l’outil Yooda pour les audits, j’avoue que c’est pas mal, mais doit être complété par des actions manuelles à mon goût. Mais ça creuse déjà bien loin.

Grand article, merci pour le partage. J’ai appris beaucoup pense que je n’ai pas la moindre idée .. Je vais certainement essayer quelques-uns d’entre eux. Grands outils de marketing.

Bonjour,

En effet, avant de lancer un site et tenter d’améliorer son SEO, rien ne vaut de bonnes fondations. Un site, c’est un peu comme une maison, si les fondations sont mauvaises, la maison risque de s’écrouler. De la même manière, un site sur un mauvais hébergeur a peu de chances de décoller (voire pas du tout).

C’est affolant, parfois, on constate un ratio entre le nombre de pages indexées et le nombre de pages qui doivent l’être. Dans ce cas, il peut y avoir un souci de contenu dupliqué…

A vitesse de chargement différente, on peut constater que certaines pages au contenu à peu près similaires ne se cotaient pas forcement dans le moteur de Google mais cela peut être du à une différence de backlinks ou bien à une tentative (in)volontaire de content spinning…

Google n’est pas toujours dupe.

Que dire des liens inutiles sortants visibles (ou uniquement dans le code) ? WordPress, en tant que CMS en est un bon exemple de système de code à optimiser.

Quoiqu’il en soit, avoir accès à Google Search Console, peut être d’une grande aide, pour débuter un audit SEO sans frais.